Tras la euforia inicial de ver como podía cargar una tabla de un dataflow gen2 directamente a una tabla de SQL Azure y todo lo que ello podía suponer, tocaba…

Primer acercamiento a Dataflow Gen2

Tras la euforia inicial de ver como podía cargar una tabla de un dataflow gen2 directamente a una tabla de SQL Azure y todo lo que ello podía suponer, tocaba…

Los usuarios de la hoja de cálculo verde están de enhorabuena ya que se encuentra operativo el conector de Flujos de Datos para Power Query en Excel de manera que…

Una pregunta tremendamente habitual: ¿Cómo puedo acceder los datos de mi modelo? ¿Sabíais que podemos conectarnos desde un flujo de datos a un conjunto de datos? Esto no está muy…

Este mes de febrero de 2021 ha estado tremendamente cargado de eventos en la Comunidad de Power BI. Por mi parte, he tenido la suerte de participar en las III…

Durante este fin de semana e impartido dos charlas en Power Platform Bootcamp de Madrid y Barcelona en la que el tema principal era el tratamiento del plegado de consulta…

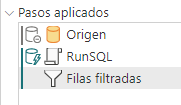

Lectura recomendada: Plegado de consultas | Microsoft Docs Todos hemos oído hablar del plegado de consultas (query folding en inglés) y no muchos conocemos exactamente de qué se trata. Por…

A principios de octubre, el genio de los dataflows Matthew Roche publicaba en su blog que ya estaba disponible la posibilidad de automatizar el refresco de los datasets dependientes de…

Como todos sabéis todos mis proyectos de Power BI los desarrolo a partir de ETL en Dataflows. Hasta ahora siempre utilizaba mis tablas de calendario, tiempo y período en DAX,…

Lo que esta mañana parecía una grandísima noticia, la llegada de los cuadros de diálogo en las consultas nativas de SQL en dataflows se ha convertido en una auténtica pesadilla…

Mediante este menú podemos agregar entidades vinculadas. Reza en su menú: “La vinculación a entidades de otros flujos de datos reduce la duplicación y ayuda a mantener la coherencia en…