Vamos a detallar los pasos a seguir para exportar un dataflow entre dos tenants diferentes o dentro de un mismo tenant entre dos espacios de trabajo diferentes, el caso es el mismo.

En este caso se trata de un dataflow cuyas conexiones son todas on cloud, por lo que no reguieren puerta de enlace.

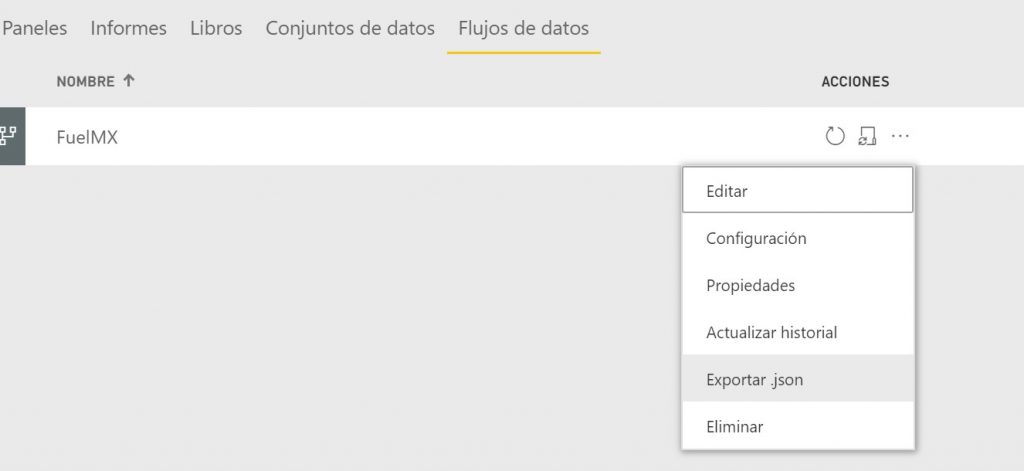

En primer lugar hay que exportar el archivo .json que contiene todas las tablas del dataflow:

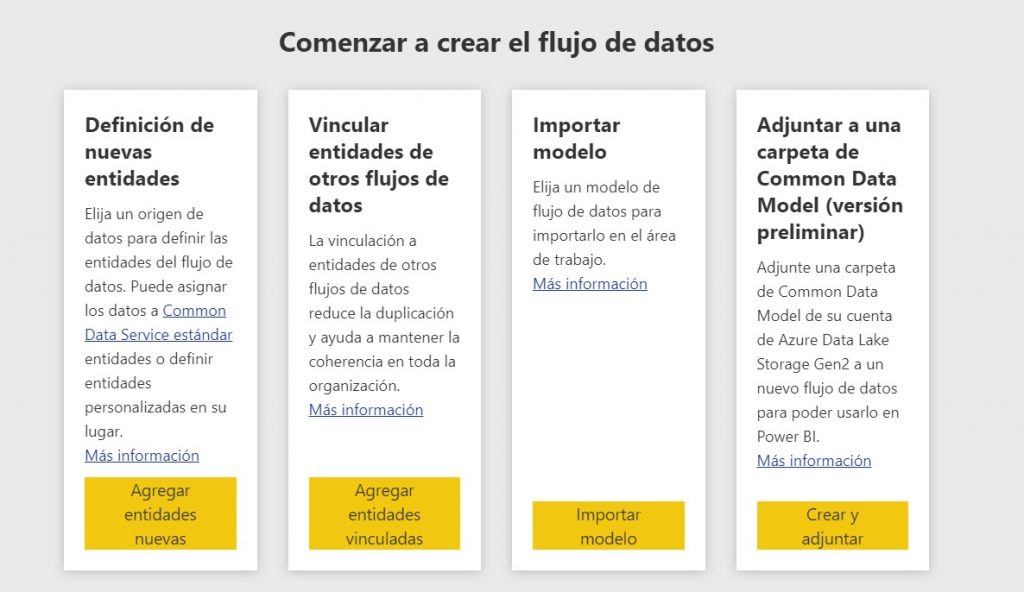

En segundo lugar, nos vamos al nuevo espacio de trabajo donde queremos importar el dataflow, le damos a crear dataflow y en la pantalla de creación le damos a Importar Modelo:

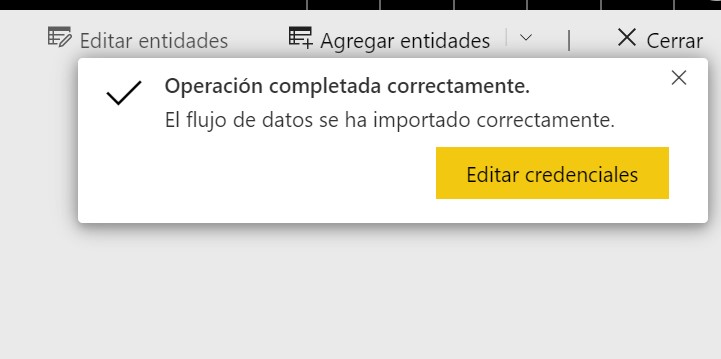

Seleccionamos el archivo .json exportado anteriormente y directamente nos va a crear el nuevo flujo de datos:

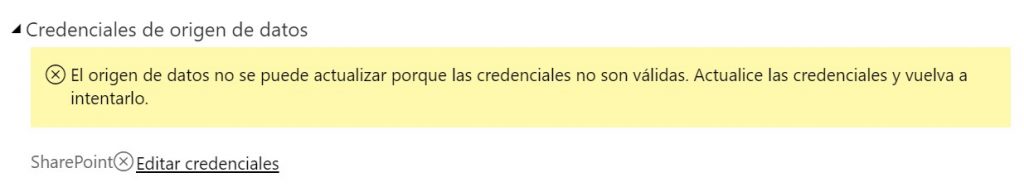

Editamos las credenciales y ya lo tenemos listo, así de simple.

Actualizamos el flujo de datos y así carga la información de las entidades.

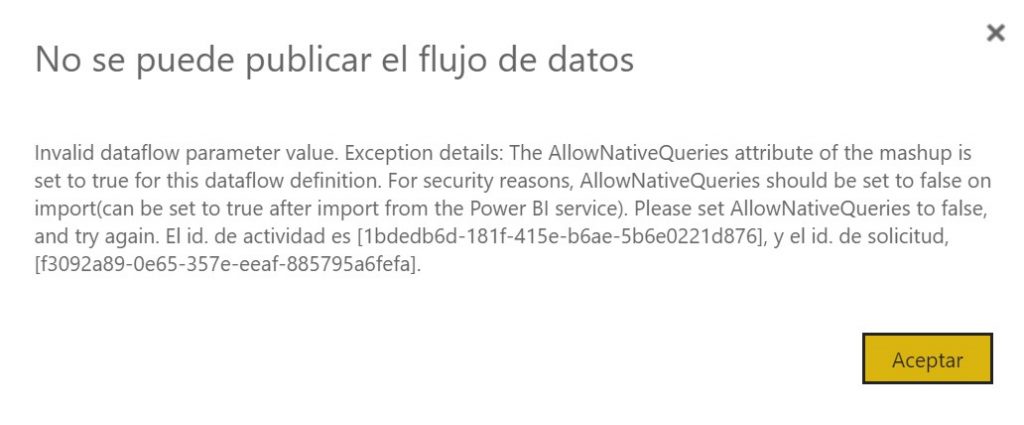

Si en el dataflow tenemos alguna query nativa, nos dará un mensaje de error como el siguiente:

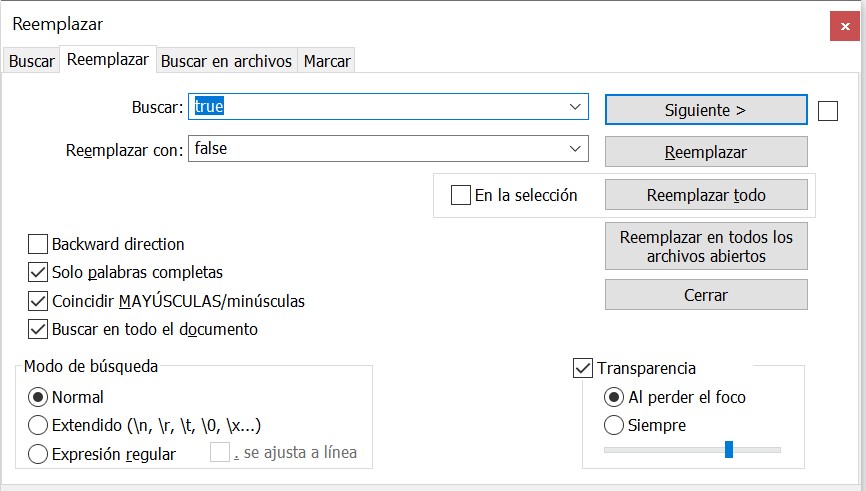

Para salvar este error es sencillo. Abrimos el archivo .json con un editor como por ejemplo Notepad++ y le decimos que busque y reemplace la siguiente cadena:

Pero solo debemos reemplazarla cuando venga predecida de “AllowNativeQuery”, el resto de trues que nos encontremos no hay que cambiarlos.

De esta forma ya se carga correctamente:

Con estos sencillos pasos podremos exportar e importar nuestros flujos de datos según lo necesitemos.

2 comentarios